AI Explorer

The AI Explorer is available on every page of LDB LIMS and enables context-related questions about the relevant data to be asked directly to an artificial intelligence(AI).

- Contextual

The AI Explorer automatically provides the appropriate context for each data record (sample, order, customer, test equipment, material, document, etc.) so that the AI provides relevant answers. - Transparency & control

You can see at any time what information is sent to the AI together with your question. You can use checkboxes to decide which data is included (or not). - Access rights

The access rights of LDB LIMS are automatically taken into account for the context. - Persistent chats

Each AI chat is saved directly with the associated data record and can be continued seamlessly at any time. - Example questions

Practical example questions provide a quick introduction to the use of AI.

User call: Presentation of AI import interfaces and AI Explorer

- Phase 1: AI import and AI Explorer

- AI-Guardrails: Steering and control

- Demos:

- Import from sampling protocols

- Import from external laboratories / user contribution

- Creating parameter formulas with AI Explorer

- Tips for everyday use - Data security: control, access rights and AI audit trail

AI Explorer integrated on every page

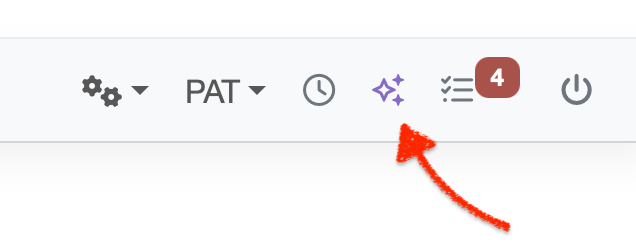

The AI Explorer is integrated directly into LDB LIMS and appears in the menu bar at the top right of every page. If you are in the sample view, for example, you can use a chat question to ask the AI for information about this particular sample - such as "Summarize the results of this sample and check the plausibility of the measurement results". The AI knows the context of the sample (master data, parameters, measured values, target values, order, etc.) and provides answers based on this in seconds directly for the sample in question.

It works in the same way on all other pages of LDB LIMS: For a customer, for example, you can ask "What orders did this customer complete last year?", for test equipment "When is the next calibration due?" etc. This contextual approach turns LDB LIMS into your personal AI assistant, which relieves you of monotonous searches and answers complex questions in an understandable way.

Context engineering

The quality of the AI's answers depends crucially on the context it receives as background information for a question. We have paid great attention to context engineering. In other words, always automatically providing the AI with exactly the right data and additional information that is relevant for the respective data type. This principle of context engineering means designing an AI system in such a way that it receives "the right information in the right format" to fulfill a task. Only if the AI receives the right context will the answer be reliable.

We have therefore built a customized context package into LDB LIMS for each data type. For example, the AI receives the parameters and for a sample request, the AI receives the parameters and measured values, limit value information, sample notes and associated order data as background knowledge. In the case of a question about a customer, for example, the order history, contact persons and open processes are provided in context. This dynamic context is compiled fully automatically in the background while you formulate your question. The result: the AI "knows" what the question is about and you receive high-quality, precise answers instead of generic outputs. This elaborate context preparation clearly sets our AI integration apart from simple AI demos - the difference between an ordinary chatbot and the AI Explorer lies primarily in the quality of the context provided.

Transparency, access rights and control

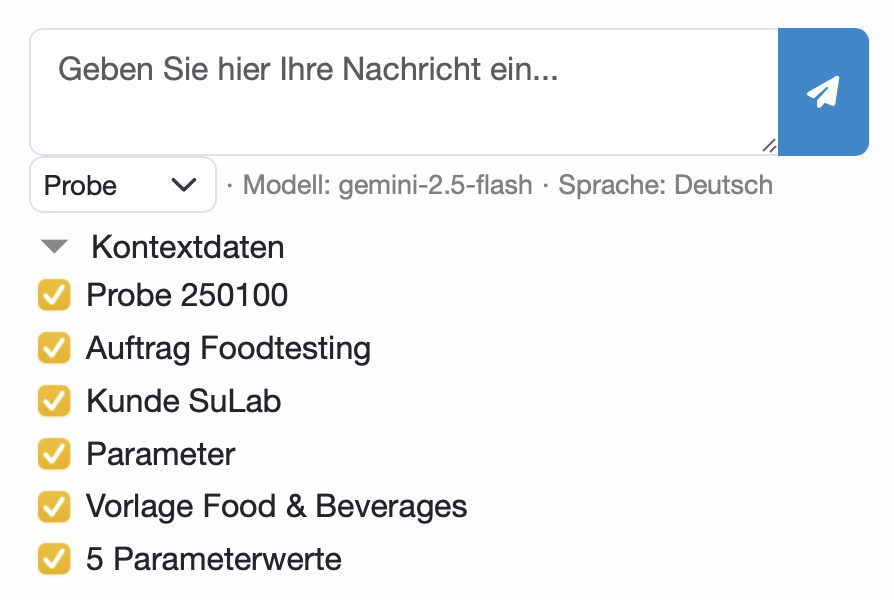

Transparency is an essential aspect of the AI Explorer. It is important to us that you can have complete confidence in the AI integration of LDB LIMS. Therefore, we list the contextual data with a checkbox for approval before it is sent to the AI model.

The access rights of the requesting user are taken into account and only data to which the user has read access is suggested. In this way, the access rights of LDB LIMS are also preserved in the use of AI and you retain full control over your data.

Persistent AI chats directly with the data record

In LDB LIMS each AI chat remains stored in the context of the respective data set and user. Imagine you have a multi-part question about a particular sample, e.g. first "Which measured values of this sample are outside the target values?" and then "What could be the possible causes of this?". The AI Explorer saves this dialog directly with the sample in question. Even weeks later, you can call up this sample and view the saved chat history, including all questions, context information and AI responses. You can seamlessly ask further questions or start a new chat about the sample.

This persistent chat history per data record has enormous advantages: On the one hand, it serves as documentation - you or your colleagues can see at any time what information the AI has given about a process. Secondly, it promotes collaboration within the team. If a laboratory manager has carried out an AI analysis on an order, a colleague can view and continue this conversation later instead of having to reformulate the questions. Knowledge and insights are not lost, but remain available where they belong - in the respective data record in the system.

Sample questions from laboratory practice

We have provided practical example questions especially for users who are working with AI for the first time. On each page you will find predefined sample questions that are relevant to the respective data type. Just click on one of these questions and the AI Explorer will answer the question with the context data of the relevant data set.

For example, a sample question for a material could be: "Which batches of this material are about to expire?" - ideal to see how the AI extracts such information from the data and answers it. For a customer dataset, an example could be: "List the most recently completed orders for this customer." These one-click questions lower the inhibition threshold and quickly show what you can ask the AI.

The sample questions are carefully selected and are constantly being expanded to provide added value and cover common use cases. In this way, we ensure that every user can easily access AI and directly achieve productive results.